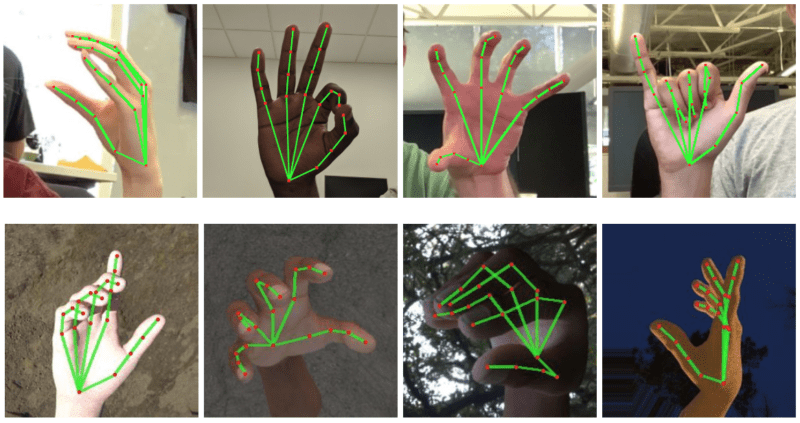

Cerca de 30 mil imagens foram adicionadas ao software, que usa machine learning para analisar um mapa da mão em tempo real

O Google anunciou, nesta segunda-feira (19), que desenvolveu uma tecnologia que entende a linguagem de sinais. A solução, que foi criada no laboratório de Inteligência Artificial da companhia, usa atalhos inteligentes e um sistema de machine learning para analisar em tempo real um mapa da mão usando uma câmera de smartphone.

A tecnologia analisa 21 pontos para entender os movimentos. Para desenvolver a tecnologia, os pesquisadores adicionaram ao software cerca de 30 mil imagens de mãos em várias posições e situações de iluminação. Além disso, renderizaram um modelo de mão em 3D com diversos fundos. O sistema então aprendeu com essas fotos para compará-las com símbolos e expressões da linguagem de sinais.

Por enquanto, a tecnologia não está sendo aplicada em nenhum produto do Google. Os códigos da solução foram hospedados na MediaPipe, plataforma aberta que permite que outros pesquisadores e desenvolvedores contribuam para o aprimoramento do software.

Planejamos estender essa tecnologia com um acompanhamento mais robusto e estável, aumentar a quantidade de gestos que podemos detectar com confiabilidade e apoiar gestos dinâmicos que se desdobram no tempo. Acreditamos que a publicação dessa tecnologia pode impulsionar novas ideias criativas e aplicativos pelos membros da comunidade de pesquisa e desenvolvedores em geral”, afirmaram os pesquisadores.